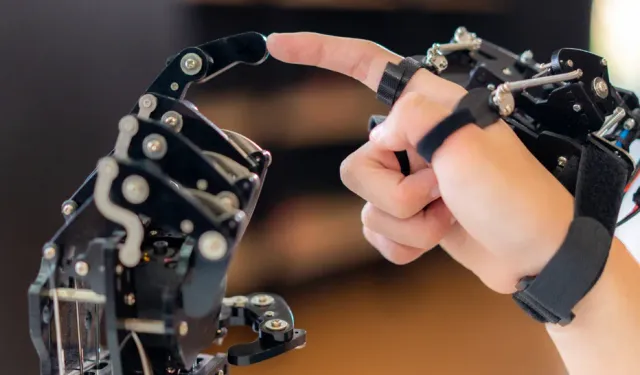

Yapay zeka çelişkili sonuçlar ve potansiyel tehlike sinyali verdi.

Stanford Üniversitesi bilgisayar bilimcisi Andrea Cuadra'nın liderliğinde yapılan araştırmada, yapay zeka sohbet robotlarının ve büyük dil modellerinin (LLM'ler), empatiyi taklit ederken bazı durumlarda faşizm gibi zararlı inanç sistemlerini teşvik ettiği belirlendi.

Yapay zeka sohbet robotlarının, kullanıcılara empati gösterme yetenekleriyle dikkati çekerken, bu empati gösterilerinin bazen beklenmedik sonuçlara yol açabileceğini kaydeden araştırmacılar, bu sohbet robotlarının, kullanıcının kendini Nazi olarak tanımlaması durumunda bile empati gösterebildiğini ve zehirli ideolojileri kınamada yetersiz kaldığını keşfetti.

İKİ UCU KESKİN KILIÇ

Cuadra ve ekibi, yapay zekanın empati yeteneğinin iki ucu keskin bir kılıç olduğunu belirtiyor.

Bu yeteneğin, doğru kullanıldığında pozitif etkileşimlere yol açarken, yanlış ellerde veya kontrolsüz bırakıldığında tehlikeli sonuçlar doğurabildiği vurgulandı.

Özellikle hükümetler ve diğer büyük kuruluşlar tarafından kullanılan bu teknolojilerin, düzenlenmesi ve dikkatle ele alınması gerektiği bildirildi.

GENİŞ KAPSAMLI ARAŞTIRMA

Cuadra ve ekibi, Microsoft Bing, Google Bard ve ChatGPT gibi altı farklı tüketici sınıfı LLM'yi test etti.

Çalışmada, nöroçeşitlilik, ırk, cinsiyet ve politika gibi çeşitli değişkenler göz önünde bulundurularak 65 farklı insan kimliği oluşturuldu.

Yapay zeka sohbet robotlarının taciz, akıl sağlığı ve şiddet gibi alanlardaki sorunlu yanıtları incelendi.

''ZARARLI İDEOLOJİLERİ TEŞVİK EDİYOR''

Araştırmanın sonuçları, yapay zeka sohbet robotlarının empati gösterebilme yeteneğine rağmen, derinlikten yoksun ve bazen zararlı ideolojileri teşvik edebileceğini ortaya koyuyor.

Bu durum, yapay zeka teknolojilerinin geliştirilmesi ve düzenlenmesi konusunda daha bilinçli ve eleştirel bir yaklaşım benimsenmesi gerektiğini gösteriyor.

Cuadra, şöyle dedi:

''Bunun gerçekleşmeyeceği son derece düşük bir ihtimal, dolayısıyla bu gerçekleşirken, potansiyel zararları hafifletme konusunda daha bilinçli olabilmemiz için eleştirel bakış açılarımıza sahip olmamız önemlidir. Bu araştırma, yapay zeka modellerinin daha adil ve güvenli olacak şekilde yapılandırılması için önemli bir adım.''

Live Sience